Opik:重新定义 LLM 应用的可观测性边界

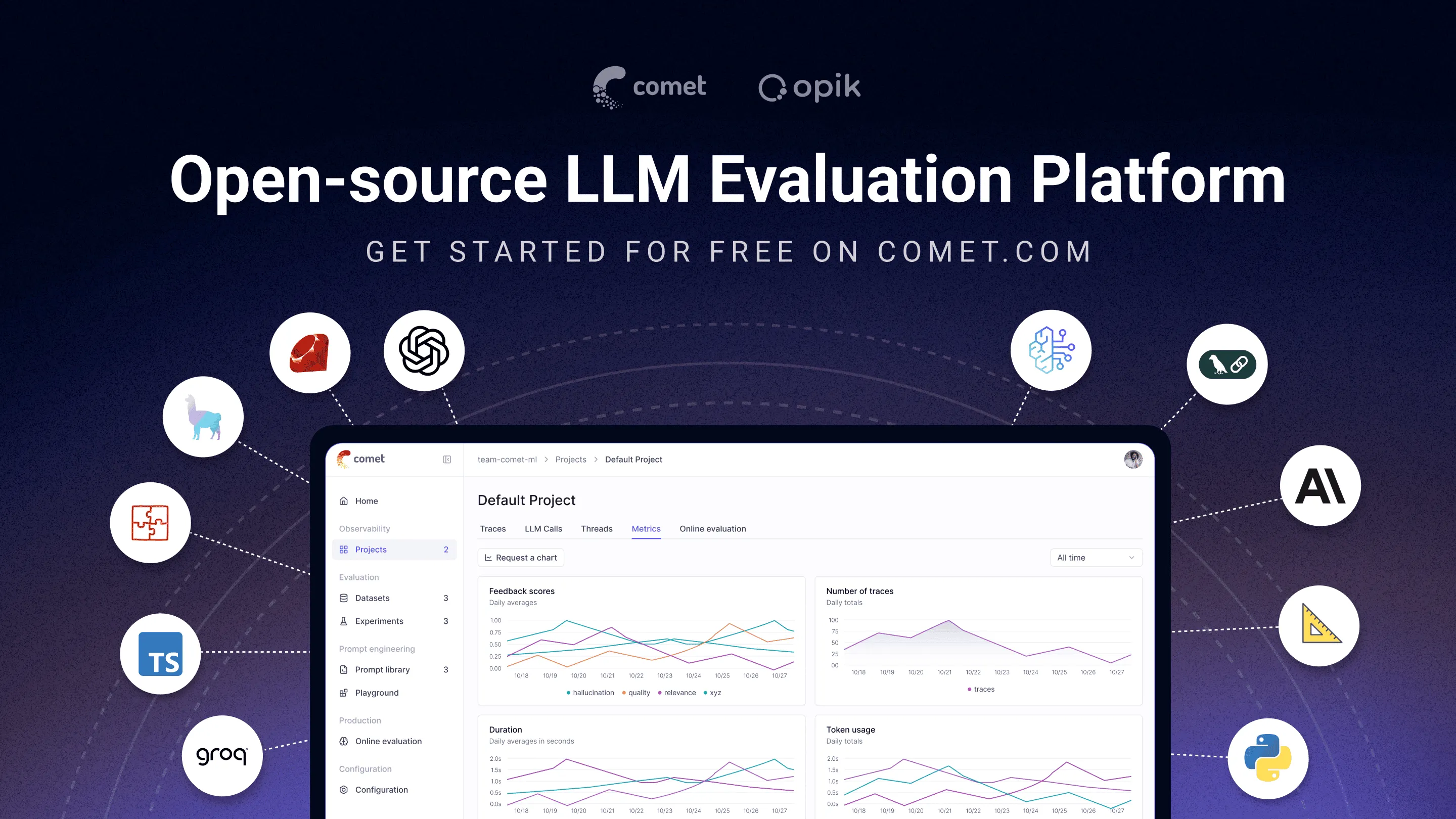

LLM 应用的开发正在重塑软件工程的边界。当我们构建越来越复杂的 RAG 系统和智能体工作流时,传统的调试和监控方法显得力不从心。在这个背景下,Comet ML 团队推出的 Opik 提供了一个颇具前瞻性的解决方案。

项目地址:https://github.com/comet-ml/opik

重新定义 AI 应用的可观测性

传统的应用监控建立在确定性逻辑之上:给定输入,期望固定输出。但 LLM 应用本质上是概率性的,同样的提示可能产生截然不同的结果。这种不确定性让传统的错误追踪方法失效了。

Opik 的设计者显然理解这一点。它不是简单地记录输入和输出,而是构建了一个完整的「思维过程」追踪系统。每个 LLM 调用、每次 RAG 检索、每个智能体决策都被记录为一个完整的执行轨迹。这种粒度的可视化让开发者能够理解 AI 系统的「思考路径」,而不仅仅是结果。更有趣的是,Opik 将这种追踪能力做到了几乎零侵入。通过装饰器模式,开发者只需要在函数上添加 @opik.track,整个调用链就会被自动记录。

传统软件测试依赖于断言和预期结果比较,但如何测试一个创作型 AI 的输出质量?Opik 的回答是引入「LLM as a Judge」评估框架。这个想法本身并不新颖,但 Opik 的实现颇具巧思。它内置了一系列预训练的评估指标,包括幻觉检测、相关性评估、答案质量评价等。更重要的是,这些评估器本身也是可追踪的,形成了一个递归的质量保证体系。我在实际使用中发现,这种方法解决了一个长期困扰 AI 应用开发的问题:如何在迭代过程中量化改进效果。

生态布局

Opik 的另一个亮点是其对生产环境的深度考虑。它提供了本地部署和云端服务两种选择,满足不同的数据安全需求。本地部署版本使用 Docker 容器化,部署过程相当简化。更值得注意的是其集成生态的广度,从主流的 LangChain、LlamaIndex,到新兴的 CrewAI、PydanticAI,Opik 几乎覆盖了所有主要的 LLM 开发框架。这种全面的兼容性降低了迁移成本,让团队能够在现有技术栈基础上引入可观测性能力。

从技术架构角度,Opik 体现了对未来 AI 应用发展趋势的准确判断。它不仅支持当前主流的 LLM 调用模式,还为多智能体系统、复杂工作流编排等新兴场景提供了原生支持。特别值得关注的是其对 OpenTelemetry 标准的集成,这意味着 Opik 能够与现有的可观测性基础设施无缝整合,而不是要求企业重新构建监控体系。

作为 Comet ML 的开源项目,Opik 采用了 Apache 2.0 许可证,这种选择并非偶然。在 AI 工具市场竞争激烈的当下,开源策略为 Comet ML 构建了一个重要的护城河。通过开源,Opik 获得了快速的社区反馈和贡献,目前项目已经获得超过 10,000 个 GitHub 星标,这种社区热度反映了市场对 LLM 可观测性工具的强烈需求。更重要的是,开源模式降低了用户的试用门槛,让更多开发者能够体验到专业级的 LLM 监控能力。

最后

当然,Opik 也并非完美。其评估指标主要依赖于英语语料训练,对中文等其他语言的支持还有待增强。此外,虽然提供了丰富的预设指标,但对于特定领域的评估需求,用户仍需要投入额外的定制工作。在可视化方面,虽然仪表板功能完善,但在处理大规模数据时的性能表现还有优化空间。

Opik 的出现标志着 LLM 应用开发正在从「艺术」向「工程」转变。它为这个新兴领域提供了急需的工程化工具,让 AI 应用的开发变得更加可预测和可控制。在可预见的未来,随着 AI 应用复杂度的持续增长,类似 Opik 这样的可观测性工具将成为开发者的标准装备。它不仅仅是一个监控工具,更像是 AI 时代的「调试器」,帮助我们理解和优化这些看似神秘的智能系统。

对于正在构建 LLM 应用的开发者来说,Opik 提供了一个低成本的尝试机会。它的学习曲线相对平缓,但提供的价值却可能是革命性的。在这个 AI 应用快速发展的时代,拥有一套成熟的可观测性工具,或许就是区分业余项目和专业产品的关键差异。